AIのセキュリティ脅威とリスク

先日、IPAから下記の資料が公表されました。

「米国におけるAIのセキュリティ脅威・リスクの認知調査レポート」

https://www.ipa.go.jp/security/reports/technicalwatch/20240530.html

生成AIの台頭により、AIの利用が爆発的に普及したわけですが、AIにだって当然様々なリスクや脅威があります。

生成AIを使っている方なら「ハルシネーション」という用語を聞いたことがあるかと思います。

ChatGPTなどの生成AIが、さも本当のことのように大嘘を回答してしまう問題ですね。

現状の生成AIの仕組みでは、この「ハルシネーション」を完全に防ぐことは不可能です。

ですので、生成AIを使いこなすためには、回答の裏付けを取るなどして、この問題をうまく回避することが重要になります。

これと同じように、AI全般についても、そのリスクや脅威を知り、予め対応を決めておくことが重要となります。

ひとつ、前述の資料でも挙げられていた脅威を例にとりましょう。

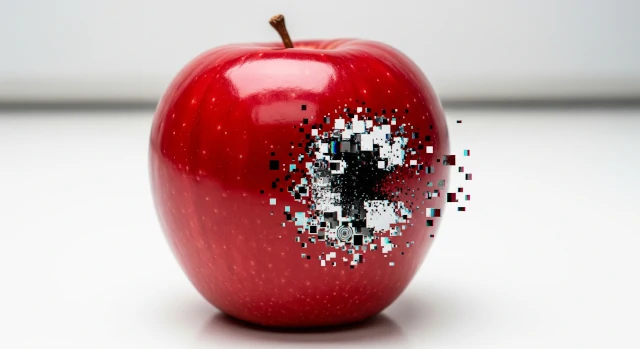

これは私も非常に懸念しているのですが、『AIのデータポイズニング(データ汚染)』という脅威があります。

情報処理技術者の方であれば、「DNSキャッシュポイズニング」というサイバー攻撃を聞いたことがあるかと思います。

悪意のある人物が細工を施した通信を行うことで、「DNS」というドメインを管理する機能に、誤ったデータを記憶させる攻撃です。

これと同じように、AIの学習に悪意のあるデータを潜り込ませることで、AIに誤った回答をさせるように仕向けることが、理論上は可能です。

このような行為を指して、『AIのデータポイズニング』と呼ばれています。

とはいえ、『AIの学習データを操作するなんて、内部の人間じゃないと無理だよ』というご指摘もあるかと思います。

確かに、学習データを『直接的に』操作するなら、そういう立場の人間でないと難しいでしょう。

では、『間接的に』ならどうでしょうか?

同資料にも記載されていますが、ある研究グループによれば、インターネット上の百科事典「Wikipedia」を編集することで、学習データに影響を与えられることを発見したとされています。

誰でも編集が可能な「Wikipedia」を編集することが、特定の人しか関与できないはずの「学習データ」を操作することにつながるわけです。

そもそも、現在のAI(特に生成AI)では、『大量のデータを元に学習』することでAIとしての能力を手に入れています。

では、その大量のデータはどこから来るのでしょうか?

全部手作業で作りますか?

何十億、何兆というデータを?

しませんよね、そんなこと。

もっと効率よくデータを収集できる場所、インターネットがそこにあるのですから。

すなわち、学習データに直接手を加えるのではなく、学習データの収集元に手を加えれば、結果として学習データを操作できるだろうというのが、この技法です。

また、『AIのデータポイズニング』が、特に脅威であると感じている理由は他にもあります。

それは、『AIの基本データは、使いまわされている』という点です。

最近では、OpenAI社のAPIなどを利用して、自社用にカスタマイズした生成AIを使用する企業も増えてきています。

それ自体は何の問題もない、むしろ素晴らしいデジタル技術の活用例だと思うのですが、『生成AIをゼロからフルスクラッチで作っているような企業はほぼない』という点が、今回問題になります。

生成AIに限らず、データを学習したAIを用意するというのは、非常にコスト(技術的、経済的両方)のかかる作業です。

ですので、自社用のカスタマイズをしている企業でも、『ベースはOpenAI社の学習データを使い、そこに自社のデータを加える』というような作りで構築しています。

ということは、です。

もし、ベースに使用している『OpenAI社の学習データ』を操作することができれば、世界中の何百万という企業に対して、一斉にサイバー攻撃を仕掛けられるということになります。

しかも、生成AIの機能のおかげで、言語や文化といった障害は勝手に乗り越えてくれます。

Wikipediaの適当な記事に大嘘の内容やURLを記載して、それが学習されるように仕向ければ、簡単にフィッシング詐欺へ悪用できてしまいます。

もちろん、記事の書き換え作業なども、全てコンピュータにやらせるでしょう。

記事の内容は生成AIに、もっともらしいことを書かせればいいわけです。

URLさえフィッシングサイトに繋がっていれば目的は達成できます。

このように考えると、ベースに使用されている学習データが汚染されるということが、どれほど危険なことかお分かりいただけると思います。

もちろん、先に挙げた「ハルシネーション」と同じように、『これは嘘だぞ、フィッシング詐欺の回答だ』と判別して回避できれば問題ありません。

ただ、冒頭に挙げた調査資料によると、人間はAIの回答を信用しすぎてしまう傾向があるそうですので、言葉で言うほど簡単ではなさそうです。

もっとも、このような攻撃はまだ現実になっていません。

これは幸いなことです。

今のうちから、『そのAIは何を学習しているのか』ということに気を配り、『この回答は汚染されていないか』という観点で回答を疑問視できれば、影響を抑えることができるでしょう。

また、リスク対策という面からは、『残念ながら、ベースが汚染されてしまったときのこと』も考えておく必要があるでしょう。

生成AIなどが分かりやすいですが、データを学習するというのは、ものの数時間で終わるような簡単な作業ではありません。

仮に悪意のあるデータが特定できて、それを除去して再学習するとしても、日単位で時間がかかります。

当然、各企業のAIも、日単位で使用できなくなります。

お気づきでしょうか?

これはもはや、BCPが発動するほどの影響力を持った事態です。

企業活動に極めて大きな影響があり、代替手段などを以って業務を遂行しなければいけない状況です。

何の準備もしていなかったら、完全にパニックに陥るでしょう。

このように、AIの活用度が上がるほど、それが使えなくなった時のリスクも大きくなります。

活用する方法だけでなく、ある日突然活用できなくなった場合のアクションも、事前に検討しておくことが求められるようになるでしょう。

そんなこんなで、私としては『AIのデータポイズニング』を一番気にしています。

もちろん、AIのリスクはそれだけではありませんので、興味のある方には、ぜひIPAの資料を読んでみていただきたいです。

概要を読むだけでも十分な情報を得ることができるかと思います。

「米国におけるAIのセキュリティ脅威・リスクの認知調査レポート」

https://www.ipa.go.jp/security/reports/technicalwatch/20240530.html

それでは、AIのリスクについて少し詳しくなった、山本慎一郎でした。